-

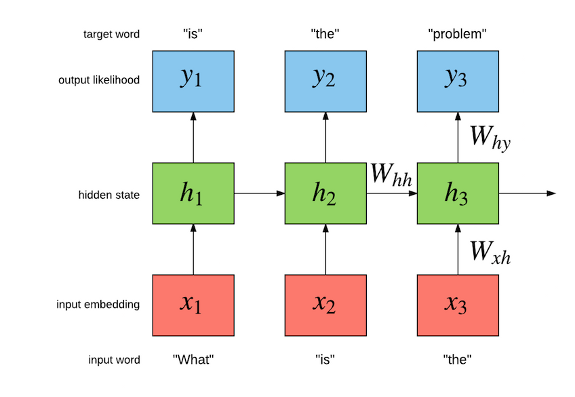

2016 年 7 月 25 日 十亿词的语言建模

噪声对比估计用于在 Google 十亿词数据集上训练多 GPU 循环神经网络语言模型。 </img>

</img> -

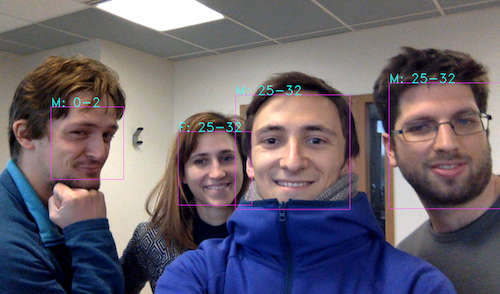

2016 年 6 月 1 日 OpenCV 和 Torch 的深度乐趣

在这篇文章中,我们将使用 OpenCV 3.0 + Torch 来构建年龄和性别分类、NeuralStyle、NeuralTalk 和实时图像分类的实时演示。 </img>

</img> -

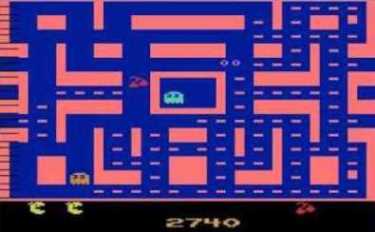

2016 年 4 月 30 日 对战深度 Q 网络

深度 Q 网络在强化学习领域取得了巨大进步,在雅达利 2600 电子游戏领域实现了超人的表现。在这篇文章中,我们将解释它们的工作原理,并讨论自 Google DeepMind 在 Nature 上发表论文以来的部分发展——尤其是对战 DQN。 </img>

</img> -

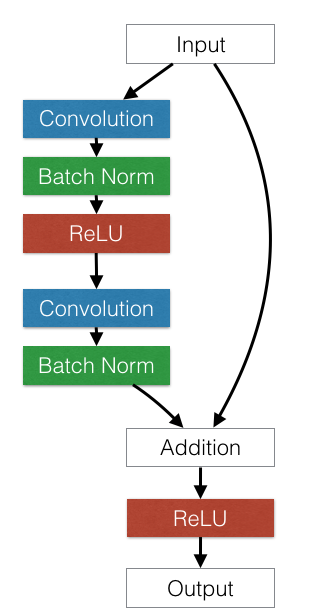

2016 年 2 月 4 日 训练和调查残差网络

在这篇博文中,我们实现了深度残差网络(ResNet)并从模型选择和优化角度调查了 ResNet。我们还讨论了多 GPU 优化以及训练 ResNet 的工程最佳实践。最后,我们将 ResNet 与 GoogleNet 和 VGG 网络进行比较。 </img>

</img> -

2015 年 11 月 13 日 使用 Torch 生成人脸

在这篇博文中,我们实现了生成对抗网络 (GAN) 并训练它来输出人脸图像。GAN 训练起来 notoriously 困难,我们探索了几个技巧来稳定/加速收敛。此外,我们将 GAN 与变分自编码器相结合,得到一个能够生成有趣图像的编码器/解码器架构! </img>

</img> -

2015 年 9 月 21 日 视觉注意力的循环模型

视觉注意力模型最近在目标检测和图像字幕方面取得了成功。看到这些模型具有类似人类的注意力,尤其令人感兴趣。在这篇文章中,我们将讨论我们对循环注意力模型的实现,其中涉及一些强化学习,以及见解和代码。 </img>

</img> -

2015 年 9 月 7 日 空间变换网络的力量

空间变换器是一种令人兴奋的新型可学习层,可以插入 ConvNet。我们表明,在 ConvNet 中使用这些层可以使我们使用更小的网络获得最先进的精度。我们还探索和可视化了变换层中发生的学习。 </img>

</img> -

2015 年 7 月 30 日 Torch 上的 CIFAR-10 92.45%

CIFAR-10 是一个流行的视觉数据集,用于尝试新想法。我们表明,使用批次归一化和类似 VGG 的卷积网络架构的简单组合,可以在数据集上获得有竞争力的基线。 </img>

</img>

</body> </html>